Definición de la palabra "informática"

La palabra informática viene de la unión de dos términos (infor-mación, auto-mática). Información, ya que se difunden datos que son procesados y reconstruidos en algo nuevo de forma automática y transmitiendo estos nuevos datos.

¿Qué es la informática y cuáles son sus características? Concepto y definición

Se puede decir que la informática es aquella ciencia que estudia la información y todos los medios que se usan para la automatización y transmisión de los procesos, para luego transformar los datos y tratarlos en algo nuevo.

Podría decirse que la materia prima de la informática es la información que se utiliza, esto porque si esta no existiese no se podrían realizar tareas finales como por ejemplo: ¿Cómo puedes sacar dinero del cajero de tu banco, si no le transmites la información de tu cuenta a través de tu tarjeta o clave de seguridad?

El cajero necesita esta información para trabajar, validar tu identidad y a su vez para suministrar el dinero solicitado. Esta tarea obviamente lleva otros procesos informáticos que no mencionaremos a detalle, pero seguramente caes a cuenta que dicho proceso es complejo.

El objetivo de esta área es el ¿Cómo tratar dicha información? Para de este modo transformar esos datos en algo nuevo y transmitirlo al usuario. Es decir que, con solo brindar unos sencillos datos se puedan lograr cosas con mayor complejidad simplificando las tareas y el trabajo.

Características de la informática

Estas características pueden ser muy variables, pero en diferentes sistemas informáticos son muy comunes, pues si bien es cierto siempre van a requerir que sea transmitida previamente una información para realizar alguna tarea.

Entre las características tenemos.

- Generan ahorro en tiempo, mano de obra y comodidad para los usuarios a la larga.

- La mayoría de equipos informáticos son de fácil uso y con estándares de calidad que brindan una mejor experiencia a los usuarios.

- Un sistema informático debe ejercer un procesamiento automático de toda la información que se le suministre, este puede hacerse mediante dispositivos electrónicos que usen sistemas computacionales.

- Deben cumplirse tres reglas básicas: (El conjunto de estas tres tareas se conoce como algoritmo)

- Entrada (captación de la información), que es cuando se le suministra alguna información. Periféricos de entrada.

- Procesamiento, donde se procesa y analiza toda la información.

- Salida (transmisión de los resultados), la información suministrada es procesada y calculada a altas velocidades realizando todos los cálculos necesarios, y dependiendo de la tarea solicitada los resultados deben enviarse y mostrarse. Periféricos de salida.

- Se debe almacenar la información digitalmente, gracias a esto hace que se pueda recuperar cualquier archivo posteriormente con el menor margen de pérdida.

- Brinda al usuario eventual una interfaz para el manejo del sistema y la satisfacción de sus necesidades de información.

- Transmitir o compartir dicha información con otros sistemas informáticos a través de redes o telecomunicaciones.

Historia de la informática

El desarrollo de esta ciencia inició a mediados del siglo XX, comenzando así con grandes avances como lo fueron: el circuito integrado, la creación del primer computador, el Internet y el teléfono móvil.

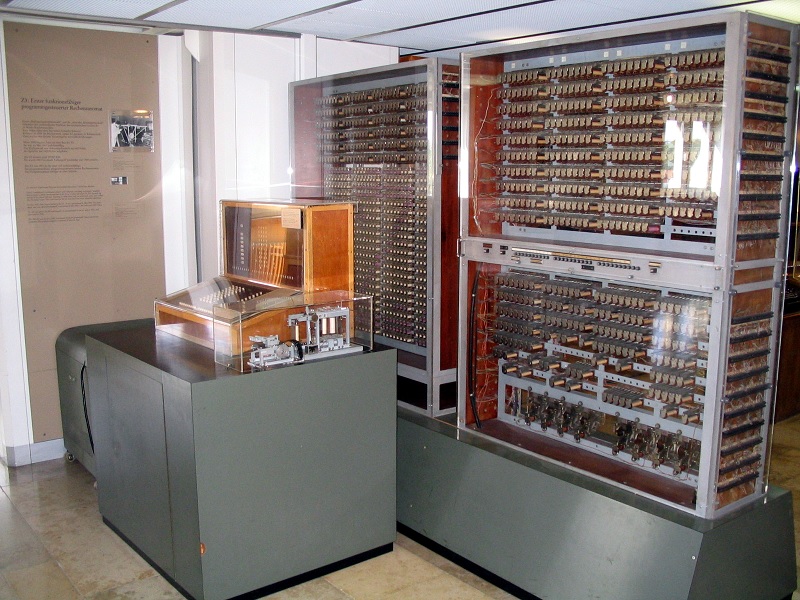

La primera máquina que realizaba procesos automáticos a partir de un algoritmo que existió se llamó Z3 y fue inventada por el científico alemán Konrad Zuse, en el año 1941. Dicho equipo tenía un peso de una tonelada. Un peso increíble y difícil de creer para la tecnología moderna.

Pero para aquella época, los elementos electrónicos que conformaban al computador eran muy grandes y pesados. La misma podía realizar operaciones sencillas como sumas en 0.7 segundos y multiplicaciones o divisiones en tres segundos.

La palabra informática fue usada por primera vez en la década de los 60 en Francia por el ingeniero Philippe Dreyfus, quien unió las palabras "information" y "automatique", (información y automática), naciendo como resultado, informática. Anteriormente a este suceso, en el año 57 Karl Steinbuch usó la palabra "informatik" en el título de un documento publicado.

Origen

El origen proviene mucho más atrás de lo que muchos pueden creer, ya que asocian esta ciencia con tecnologías modernas como la electrónica y programación. Pero en realidad la informática surgió en la antigüedad con la creación de diversos métodos que eran usados para realizar cálculos matemáticos.

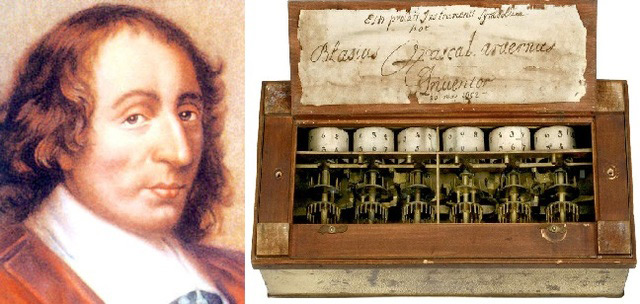

Durante la época de 1600 hasta 1700 ocurrieron increíbles e importantes avances científicos de la mano de uno de ellos, Blaise Pascal, el cual diseñó y construyó en el año 1642 la primera calculadora mecánica que funcionaba, la calculadora de Pascal.

En la época de 1673, Gottfried Leibniz, demostró una calculadora digital mecánica llamada Stepped Reckoner. Este científico puede ser considerado el primer informático de la historia. Uno de sus descubrimientos más importante fue el sistema numérico binario.

Los años siguientes, ya prácticamente de manera continúa el ser humano ha ido creando nuevos métodos para automatizar los procesos de trabajo, y de esta manera mejorar la productividad y calidad del mismo.

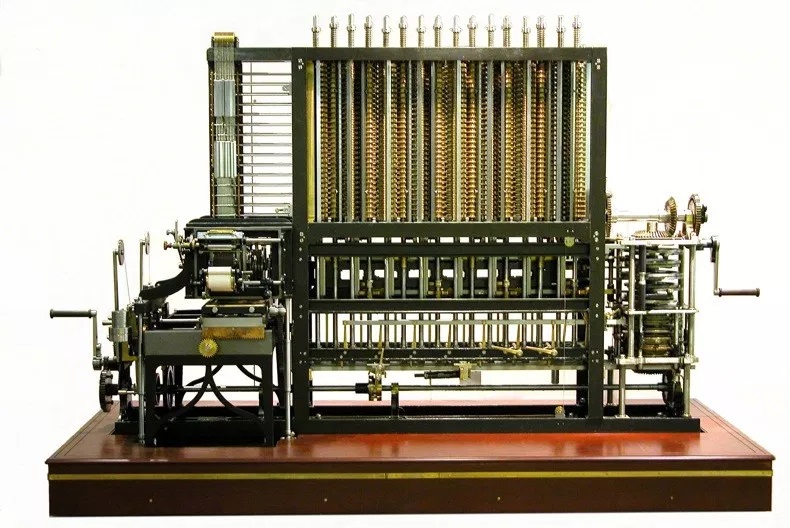

Se crearon nuevas máquinas de cálculo como las calculadoras Difference Engine (Máquina diferencial) y Analytical Engine (Máquina analítica), sucesora de la anterior nombrada, ambas diseñadas por Charles Babbage (1791-1871). Esta máquina innovo con la implementación de tarjetas perforadas permitiendo que se pudiera programar de diferentes formas la Analytical Engine.

De esta forma en 1843, durante la traducción de un artículo en francés de Analytical Engine, Ada Lovelace (1815-1852) logró escribir lo que hoy es considerado como el primer programa de computación de la historia, el cual servía para computar números de Bernoulli.

Evolución

La informática ha tenido una serie de increíble y largos cambios durante toda su historia, esta empezó realizando una serie de lenguajes de programaciones simples, que luego se fueron transformando en tareas más complejas a medida que aparecieron nuevas funciones informáticas y nuevas tecnologías que ayudaban a transmitir mejor la información, almacenarla y transformar la misma de forma más sencilla.

Esto ha permitido que se desarrollaran las máquinas programables como lo son: computadoras, dispositivos electrónicos, móviles y automóviles. Estos equipos de uso informático son de gran utilidad en diversas áreas como la medicina, la robótica, el transporte, la administración y gestión empresarial, procesos industriales, y muchos más.

De hecho, la informática ha dado origen a la llamada Era de la Información, propulsora de la Revolución de la Información, es vista como el tercer mayor progreso tecnológico de la humanidad estando a la par con la Revolución Industrial (1750–1850, de nuestra era) y la Revolución Neolítica (agricultura) (8000–5000 antes de Cristo).

Futuro

El futuro de la informática puede ser algo incierto, esto debido a los constantes cambios que está teniendo el mundo en la actualidad, y es fácil de ver, ya que los saltos y la evolución de las tecnologías son cada vez mayores y en menor margen de tiempo.

Pero hay algo que no va a cambiar y será la seguridad informática, pues actualmente esta área está agarrando cada vez más importancia, debido a que el mundo actual se está modernizando y son más los sistemas informáticos encargados de la vida diaria. Esto consecuencia a que son más las personas que usan y almacenan datos en sus equipos informáticos, ordenadores, móviles, etc.

Así que se puede decir que, en un futuro, se tomará mayor relevancia en la protección de los datos de los usuarios para así lograr mayor fiabilidad y credibilidad en esta rama.

La informática se ha vuelto un pilar muy importante para la humanidad, y aunque ya la misma ejerce una gran ayuda en otras áreas como electrónica, electricidad, física, matemática, diseño gráfico, arquitecturas y otras áreas, cada día los programas usados obtienen mejoras y nuevas herramientas que ayudan a simplificar la labor, ahorrando tiempo a sus trabajadores y usuarios.

Es por ello que, aunque parezca que no existen lugares nuevos para la informática, la misma busca crecer y evolucionar para de esta manera ayudar en un futuro a crear mejores tecnologías como es el caso de la IA o inteligencia artificial, todo un reto y ya una realidad para los sistemas informáticos.

Las unidades de medida en la informática

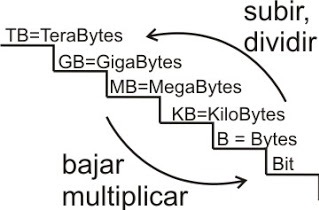

Existen dos unidades de medida, estas son para medir el peso (espacio) de un archivo y la velocidad con la que se transmite una información o documento, y la otra unidad es la que se usa para indicar con la que se hace o concluye un proceso.

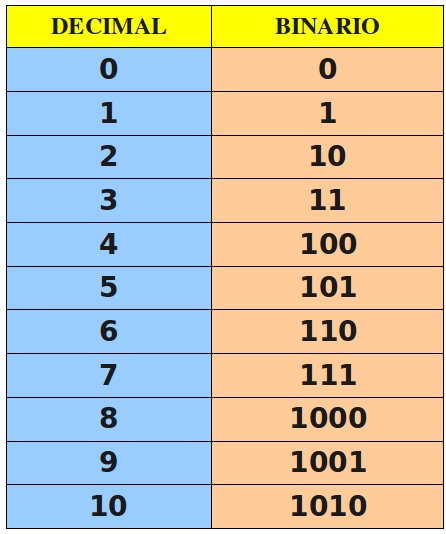

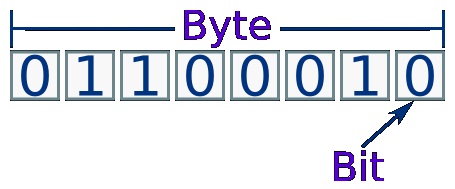

La unidad más pequeña de medida es el bit, este se puede considerar como el estado de un interruptor (abierto o cerrado) donde cada estado está representado por un dígito binario 0 o 1.

Los bits son agrupados en bytes conjuntos de 8 bits. Aunque formalmente pueden existir bytes de entre 6 y 9 bits, pero mayormente encontrarás bytes de 8 bits, a estos se les llama también octetos.

Memoria y almacenamiento

El bit puede ser usado para indicar una medida de almacenamiento de datos. Entre mayor sea el espacio del archivo, bit ocupará mayor espacio. Es importante indicar que para la memoria y el almacenamiento se utiliza el sistema binario, donde cada unidad son 1024 de la unidad anterior, así pues tenemos:

- 1024 bytes son 1 Kilobyte (K, KB,)

- 1024 KB son 1 Megabyte (Mega, MB,)

- 1024 MB son 1 Gigabyte (Giga, GB,)

- 1024 GB son 1 Terabyte (Tera, TB,)

- 1024 TB son 1 Petabyte (Peta, PB)

- 1024 PB son 1 Exabyte (EB)

- 1024 EB son 1 Zettabyte (ZB)

- 1024 ZB son 1 Yottabyte (YB)

Realmente luego de superar la barrera del Terabyte la cantidad de espacio se hace parcialmente infinito para un usuario promedio, ya que la cantidad que se encuentra disponible de este para almacenamiento es tan amplia que no podrá llenarlo en mucho tiempo.

Velocidad de transmisión de datos

En este caso sí es utilizado el sistema decimal (sistema internacional) y por tanto las unidades son múltiplos de 10 y no de 2. Aquí se usa como base los bits por segundo (bps).

Las unidades más usadas son:

- Kilobit (Kbps) = 1.000 bits por segundo

- Megabit (Mbps) = 1,000.000 bits por segundo (1.000 Kpbs)

- Gigabit (Gbps) = 1.000,000.000 bits por segundo (1.000 Mbps)

En muchas ocasiones las velocidades de Internet son medidas en kilobytes por segundo (KB/s), (contándose en bytes no en bits). Esto refleja la capacidad y la velocidad de las unidades que se transmiten por segundo, teniendo que multiplicar por 8 para así obtener la velocidad real de transmisión.

Frecuencia (procesador, memoria)

La velocidad de procesamientos del procesador, la memoria, la gráfica, etc, es medida en hercios, siendo un hercio (hz) un ciclo o repetición de un evento por segundo.

Actualmente el hercio se ha quedado atrás con la capacidad de velocidades actuales en los dispositivos, que ahora funcionan con capacidades que van desde: megahercios (Mhz, millones de hercios) o a gigahercios (Ghz, mil millones de hercios).

Entonces debido a lo anteriormente explicado, la velocidad de procesamiento del trabajo o frecuencia de un procesador es medida en megahertzios como estándar actual, estas medidas llegan actualmente a los Gigaherzios.

Hay que aclarar que un hercio es una unidad de frecuencia, la cual mide la velocidad con la que se completa una tarea o ciclo en un segundo. En el caso de los procesadores seria la cantidad de veces que es capaz de realizar una operación en un segundo.

El Bit

Se conoce como Bit al acrónimo de Binary digit. (dígito binario). Un bit es un dígito del sistema de numeración binario. Mientras que en el sistema de numeración decimal se usan diez dígitos, en el binario se usan sólo dos dígitos, el 0 y el 1, por lo que solo puede representar uno de esos dos valores.

El Byte

En informática se representa un carácter (letra, símbolo o un número) utilizando una combinación de 8 bits (8 ceros y unos) según un código llamado ASCII. Por ejemplo, la letra A es el número 10100001. ¿Cuánto ocuparía un documento formado por 1000 caracteres? Pues sencillamente 1000 bytes, lo que significa que cada carácter es un byte.

El bit y el byte

De esta manera podemos ver que se utiliza el byte como "La unidad básica de almacenamiento en informática". En realidad, es la más básica, la más pequeña es el bit.

Bits por Segundo

Son usados en el caso de definir las velocidades de transmisión de los datos, se suele usar como base el bit, y más concretamente el bit por segundo o bps. ¿Qué es un Bit por segundo? Es la cantidad de bits que se transmiten en un segundo.

Los múltiplos más utilizados son el Kilobit, Megabit y Gigabit y siempre deben ser expresados en el término por segundo (ps). 1 Kbps = 1.000 bits por segundo. Mbps.- = 1.000 Kbits por segundo. Gbps.- = 1.000 Mbits por segundo. Es importante tener en cuenta que se habla de bit (bits) y no byte (bytes), es un error muy común que se suele confundir.

Conversión de unidades informáticas

Si son usado Bytes la tabla de conversión seria la siguiente:

- 1 kilobyte (Kb) 1024 bytes

- 1 Megabyte (Mb) 1024 kilobytes

- 1 Gigabyte (Gb) 1024 Megabytes

- 1 Terabyte (Tb) 1024 Gigabytes

Los bits es lo mismo (1024). El motivo de que la proporción entre las distintas magnitudes sea de 1024 se debe a que esta cantidad es la potencia de base 2 que más se aproxima al múltiplo 1000 (210=1024), equivalente al prefijo kilo.

En el caso de los hertzios seria:

- 1Khz 1000Hz

- 1Mz 1000Khz

- 1Ghz 1000Mz

Ventajas y desventajas de la Informática

Esta ciencia y los avances tecnológicos que ha traído para la humanidad han generado una mejora en el nivel de vida, esto porque ha permitido la realización de actividades de una forma más simple, sencilla y eficaz.

Aunque como todas las tecnologías puede presentar algunos inconvenientes, por eso te presentaremos una lista de algunas ventajas y desventajas de la misma.

Ventajas

Sencillamente las ventajas son mayores que las desventajas, y brindan mejoras considerables en diferentes ámbitos de la vida diaria que resulta impensable para los regímenes actuales de la humanidad vivir sin la misma.

Entre sus beneficios están:

- Incremento en la producción y difusión de nuevas tecnologías.

- Permanencia y mejora en la comunicación con amigos, familiares o trabajo alrededor del mundo, por una fracción del costo de una llamada telefónica o correo aéreo.

- La comunicación actual es más rápida y puede realizarse en tiempo real sin problemas.

- Exploración de bibliotecas y bases de datos de información globalmente, teniendo información prácticamente ilimitada al alcance de tus manos.

- Acceso a documentos, diarios, programas y cualquier otra fuente de información.

- Servicio de noticias de cualquier tipo, desde deportivas hasta información meteorológica.

Desventajas

Aunque resulte difícil de ver, todas las tecnologías traen consigo algunas desventajas que pueden ser muy graves, o solo presentar inconvenientes que se pueden solucionar al momento o en un futuro próximo, entre ellas están:

- Se realizan muchos plagios de información en Internet cuando se realizan tareas o trabajos de investigación, e incluso redacciones para brindar información. Lo que provoca que cada vez sean más las personas que no desarrollan o aumentan su capacidad analítica y un pensamiento crítico.

- La seguridad informática es un tema importante, la cual tiene momento de alta vulnerabilidad, esto producto a virus informáticos que pueden dañar tu ordenador y generar problemas graves con tus datos personales e incluso pudiendo robarlos para suplantar tu identidad, es por ello tan importante instalar los mejores antivirus para protegerte.

- Es más común la descarga de programas inapropiados y paginas no aptas para menores.

- Los hackers con motivos maliciosos son una amenaza continúa.

- Puede existir problemas de conexión, que sea lenta o que no se encuentre disponible.

- Se ha popularizado la creación de noticias falsas, o contenido falso en la web, lo que hace propenso a crear desinformación o una mala imagen de otras personas por sucesos que nunca han ocurrido

Principales conceptos de la informática que deberías conocer

Estos conceptos son terminologías de algunos elementos importantes en la informática, que si bien no están de más que los conozcas para así tener un mejor entendimiento de esta área tan importante actualmente.

- Información: Conjunto de datos que son suministrado para indicar una función o dar una orden.

- Automática: Acción que se realiza sin la intervención de un ente externo al dispositivo, con la finalidad de obtener un producto final. Ejemplo de esto: Una calculadora que realiza los cálculos de alguna cuenta, donde solo se necesita indicar la cantidad y que se desea hacer, para de manera automática obtener un resultado.

- Sistema informático: Son los componentes de hardware necesarios para la explotación de las aplicaciones informáticas o de software en un dispositivo.

- Computadoras u Ordenadores: A las computadoras (del inglés, "computer"), también se les llama ordenador (del francés, "ordinateur") o equipos informáticos.

- Programas: Es un conjunto de instrucciones u órdenes que indican al dispositivo electrónico las operaciones que el mismo debe realizar con unos datos determinados. Por lo general, el programa indica al dispositivo cómo entregar unos datos de salida a partir de unos datos de entrada.

- Sistema Operativo: Sirve de intermediario (interfaz) entre los programas y el ordenador u dispositivo electrónico con el usuario. De forma que, cuando un usuario ejecuta un programa, éste solicitará al sistema operativo las acciones que se deben realizar para solventar las necesidades del usuario que está haciendo uso del dispositivo.

- Hardware: El término hardware se refiere a todas las partes físicas de un sistema informático, es decir, sus componentes.

- Software: Se conoce como software al soporte lógico de un sistema informático, que comprende el conjunto de los componentes lógicos necesarios que hacen posible la realización de tareas específicas

- Humanware: Es la parte humana de un sistema informáticos. Se divide entre profesionales informáticos y usuarios.

Últimas noticias y artículos sobre Informática

Toda la información más actualizada sobre virus informáticos, el software, hardware, aplicaciones móviles, seguridad y mucho más. Descubre como evoluciona el mundo de la informática y los computadores. Mantente al día con las últimas guías, tutoriales y noticias sobre tecnología informática.