Lo Último en IP@P

- Stellar Data Recovery revoluciona la recuperación de archivos perdidos en discos duros externos

- Goblin Mine: La Estrategia Económica Detrás del Juego de Minería que está Fascinando a Todos

- Estos son los nuevos Cargadores UGREEN: potencia y portabilidad en dos versiones que no te puedes perder

- UGREEN Nexode Pro: El Cargador Ultradelgado que revoluciona la carga de dispositivos móviles

- La computación en la nube está transformando los juegos Online y estas son sus grandes ventajas

A menudo escuchamos o leemos sobre la velocidad de Internet, ancho de banda o capacidad de un pendrive o disco. Pero ¿qué son esas unidades de medida que se mencionan? ¿Conoces realmente qué representan?

Puede suceder que quieras adquirir un disco de almacenamiento y no sepas elegir entre las diferentes variedades. O que confundas un Bit con un Byte. Lo mejor para estos casos es que aprendas al respecto antes de tomar una decisión.

A través del contenido de este post, podrás conocer todo acerca de estos valores. Desde sus orígenes hasta la actualidad. Continúa leyendo para saber más.

¿Qué es una unidad de medida de información en informática y para qué sirve?

Al igual que los valores como el metro o el gramo que usamos para medir objetos, también existen las medidas para el almacenamiento de información digital. Y del mismo modo que las demás, posee una unidad mínima la cual se denomina Bit. Dicho valor (Binary Digit) representa un 1 o un 0 en el sistema binario. Esta forma de medir es la utilizada para la informática desde sus inicios. Pero para comprender mejor de que se trata es necesario conocer un poco más de su historia.

Historia y origen ¿Cuándo y por qué se establecen los sistemas de medida de información?

Más en Informática

- Visión artificial o Computer Vision ¿Qué es, cómo funciona y para qué sirve esta tecnología?

- Chatbots ¿Qué es, para qué sirven y cómo funcionan?

- Formato de archivo: ¿Qué es y para qué sirven estos estándares para identificar documentos?

- Extensión de archivos del sistema; ¿Qué son, para qué sirven y qué tipos hay?

- Código ASCII: ¿Qué es, para qué sirve y cuál es su importancia en informática e Internet?

SÍGUENOS EN 👉 YOUTUBE TV

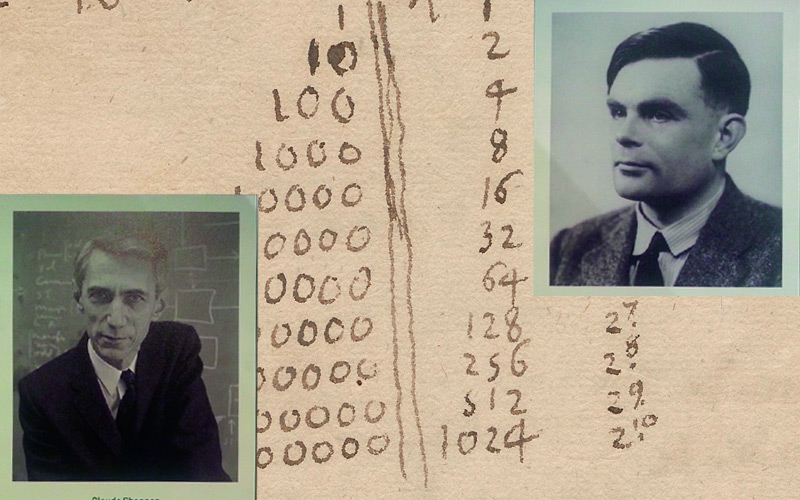

Los sistemas binarios se utilizan hace muchísimos años. Desde los egipcios, pasando por el telégrafo y hasta los padres de la era digital Touring y Shannon. Siendo este último el que une la electrónica con la lógica algebraica de Boole. Transformando sistemas de información decimal a uno más sencillo para las máquinas.

Sin embargo, no fue hasta finales de los años cincuenta con el diseño de la máquina 7030 Stretch de IBM que se elige el byte con estructura de 8 bits como modelo estándar. Debido al éxito de este ordenador los dispositivos posteriores siguieron usando dicha arquitectura. Por lo que el uso de otra cantidad de bits se volvió innecesaria.

Lista de todas las medidas de información en informática y sus equivalencias

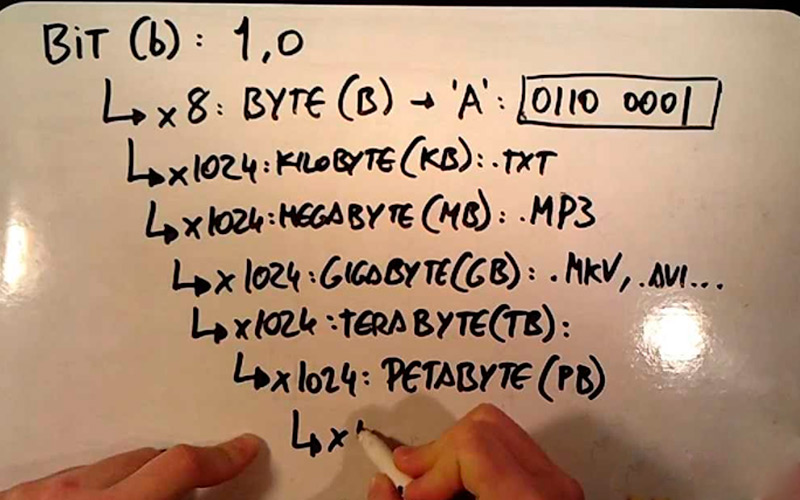

De un modo similar, la escala de unidades del sistema informático utiliza los prefijos del sistema internacional. Sin embargo, los del SI utilizan un sistema en base a 10 unidades, mientras que los binarios lo hacen en base 2. Para entender un poco mejor esto, continúa con la siguiente tabla. (Tomaremos la definición decimal para expresar los múltiplos de bits, ya que es el más usado para expresar velocidades de Internet).

Veamos a continuación:

- Bit (b). Equivale a un 1 o un 0.

- Byte (B). Es igual a 8 Bits y es el tamaño de, por ejemplo, una sola letra.

- Kilobit (kb). Es igual a 1000 bits (103). Es la unidad de medida más utilizada a la hora de indicar una velocidad de transferencia de Internet. No debe confundirse con el kB que es 8 veces mayor.

- Kilobyte (kB). Es igual a 1024 Bytes (210) puede ser el tamaño de un texto muy breve.

- Megabit (mb). Es igual a 1000 kilobits (106). En la actualidad y gracias al aumento en las velocidades de transferencia a través de la web, es posible observar esta unidad de medida por segundo en las descargas.

- Megabyte (mB). Es igual a 1024 kilobytes (220). Siguiendo con la temática, podría tratarse de una novela corta.

- Gigabit (gb). Equivale a 1000 mb (109). La aparición de la fibra óptica como método de conexión a la web ha permitido que los valores de velocidad aumenten drásticamente. Es por ello, que gracias a que permite 2gb por segundo, podemos disfrutar de Internet, teléfono y servicios de cablevisión a través de un mismo cable.

- Gigabyte (gB). Es igual a 1024 megabytes (230). Lo que significaría un estante enorme lleno de libros.

- Terabit (tb). Equivale a 1000 gb (1012) o un trillón de bits. La diferencia entre esta unidad y el tebibit (sistema binario) es de un 10%. Siendo esta última la mayor.

- TeraByte (tB). Es igual a 1024 gigabytes (240). Siendo correspondido a una biblioteca de gran tamaño.

Medidas de información en la velocidad de las conexiones ¿Cuáles son las diferencias entre MB y Mb?

Como norma internacional se utiliza el Mb como factor en el tiempo para indicar la velocidad de transferencia. Sin embargo, puede ser sencillo confundirla con el MB, es decir megabyte que es ocho veces mayor (1 Byte = 8 bit). Por ello es importante corroborar siempre esta diferencia. Sobre todo, en contratos con los proveedores de Internet. Por ejemplo, al adquirir una línea de 400 Mbps (Megabits por segundo) significará una tasa de 50 MBps (Megabytes por segundo). Un número bastante menor si se ha prestado a la confusión.