Lo Último en IP@P

- Stellar Data Recovery revoluciona la recuperación de archivos perdidos en discos duros externos

- Goblin Mine: La Estrategia Económica Detrás del Juego de Minería que está Fascinando a Todos

- Estos son los nuevos Cargadores UGREEN: potencia y portabilidad en dos versiones que no te puedes perder

- UGREEN Nexode Pro: El Cargador Ultradelgado que revoluciona la carga de dispositivos móviles

- La computación en la nube está transformando los juegos Online y estas son sus grandes ventajas

En el mundo de la informática, el código binario es una de las bases fundamentales que permite el funcionamiento de todos los dispositivos electrónicos que utilizamos en nuestra vida diaria. Desde la computadora en la que escribimos nuestros correos electrónicos hasta el teléfono móvil que utilizamos para comunicarnos con nuestros amigos y familiares, el código binario está presente en todos ellos.

A pesar de que la mayoría de las personas no están familiarizadas con el código binario, es un concepto que se encuentra en el corazón de la tecnología moderna. De hecho, es el lenguaje que utilizan las computadoras para procesar y almacenar información. Cada imagen que vemos en una pantalla, cada sonido que escuchamos a través de unos altavoces y cada palabra que leemos en una página web está representada en código binario.

En este artículo, exploraremos la historia del código binario, cómo funciona y cómo se utiliza en el mundo de la informática. Descubriremos las operaciones matemáticas que se pueden realizar en código binario, así como las diferencias entre bit y byte y las diversas escalas de estos elementos. Al final de este artículo, esperamos que tengas una comprensión más clara del código binario y de su importancia en el mundo de la tecnología.

¿Qué es el código binario y por qué se usa en Informática?

El código binario es un sistema numérico que utiliza únicamente dos dígitos: 0 y 1. Es utilizado en la informática como una forma de representar información digital, ya sea texto, imágenes, sonido, video, entre otros. En otras palabras, el código binario es la forma en que las computadoras entienden y procesan los datos.

Cada número en el código binario se llama "bit" y puede ser 0 o 1. Un conjunto de 8 bits se llama "byte", y es la unidad básica de almacenamiento de información en una computadora. Ahora, puede que te preguntes por qué se utiliza el código binario en vez de otros sistemas numéricos, como el decimal (base 10) que estamos acostumbrados a utilizar en la vida cotidiana.

La respuesta es sencilla: las computadoras están basadas en circuitos electrónicos que solo pueden entender dos estados distintos: encendido (1) y apagado (0). Por lo tanto, el código binario es la forma natural de comunicación entre la máquina y el usuario. Además, el código binario permite una representación muy eficiente de la información. Cada número o letra se puede representar con un patrón de bits, y esos patrones se pueden almacenar, transmitir y procesar de manera muy rápida y eficiente.

Anatomía del código binario

La anatomía del código binario se basa en la combinación de bits en secuencias más largas, que a su vez se agrupan en bytes y palabras de datos. Los bits son la unidad más pequeña de información en la informática, mientras que los bytes son la unidad básica de almacenamiento de información. La forma en que se utilizan los bits para representar números es un concepto importante en el código binario.

A pesar de su simplicidad aparente, el código binario es la base de la informática moderna, y es esencial para el almacenamiento, procesamiento y transmisión de información en todo el mundo. En este sistema, la información se representa mediante la combinación de dos dígitos: 0 y 1. Cada uno de estos dígitos se denomina bit, que es la unidad más pequeña de información que se puede representar en un ordenador.

Los bits son los componentes básicos del código binario. Como se ha mencionado anteriormente, solo hay dos dígitos, y estos se utilizan para representar toda la información digital, ya sea texto, imágenes, sonido, video o cualquier otro tipo de datos. La anatomía del código binario se basa en la combinación de bits en secuencias más largas.

Las secuencias de bits son esenciales para entender cómo se almacena la información en la informática. Para representar un carácter, por ejemplo, se necesitan varios bits. El número de bits necesarios para representar un carácter depende del sistema de codificación que se utilice. En el sistema ASCII, por ejemplo, se utilizan 8 bits para representar cada carácter. En otros sistemas, como el Unicode, se utilizan más bits para representar una gama más amplia de caracteres.

La anatomía del código binario también implica la forma en que los bytes se agrupan para formar palabras de datos. Una palabra de datos es un conjunto de bytes que se utiliza para representar una cantidad más grande de información. Las palabras de datos se utilizan para almacenar información como números enteros, números decimales y otros tipos de datos más complejos.

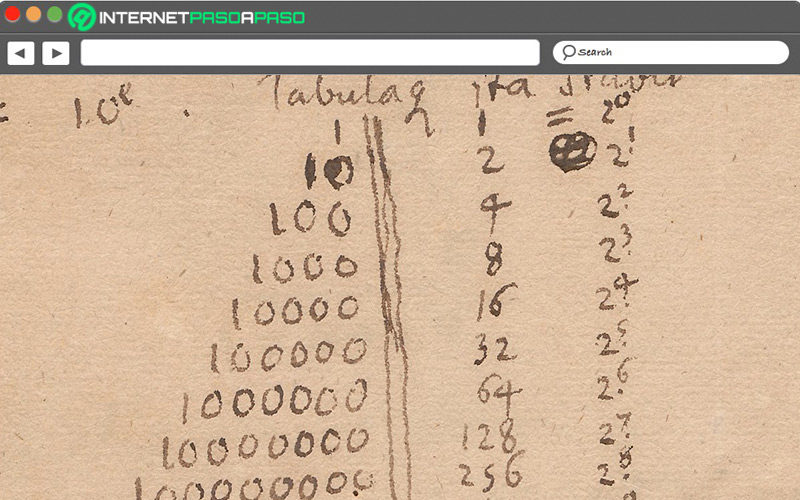

Otro concepto importante en la anatomía del código binario es la forma en que se utilizan los bits para representar números. En el sistema binario, cada posición de un número representa un valor que es el doble de la posición anterior. Por ejemplo, el primer bit de un número binario representa el valor 1, el segundo bit representa el valor 2, el tercer bit representa el valor 4, y así sucesivamente. Por lo tanto, un byte que representa el número 10101010 se traduce a 170 en el sistema decimal.

Diferencias entre Bit y Byte

Un bit es la unidad más pequeña de información que se puede almacenar y procesar en un ordenador. Representa un valor binario de 0 o 1 y se utiliza para codificar toda la información digital en el sistema binario. En otras palabras, un bit puede estar encendido (1) o apagado (0), lo que representa la forma en que la información se almacena y procesa en el ordenador.

Por otro lado, un byte es una unidad de información que se compone de ocho bits. Es la cantidad mínima de información que un ordenador puede leer o escribir a la vez en la memoria. Un byte se utiliza para representar un solo carácter de texto o un número entero entre 0 y 255. También se puede utilizar para representar una imagen en escala de grises con una resolución de 256 tonos diferentes.

Las diferencias entre un bit y un byte son importantes porque afectan la forma en que se almacena y se procesa la información en los ordenadores. Aunque los bits son más pequeños y básicos, los bytes son más útiles porque permiten al ordenador manejar más información a la vez. En la escala de medidas de información, las unidades se miden en múltiplos de bytes. Así, un kilobyte (KB) equivale a 1024 bytes, un megabyte (MB) a 1024 kilobytes, un gigabyte (GB) a 1024 megabytes, un terabyte (TB) a 1024 gigabytes, y así sucesivamente.

La escala de medidas de información se utiliza para medir la cantidad de espacio de almacenamiento en disco duro, memoria RAM y la velocidad de transferencia de datos de redes de ordenadores. Por ejemplo, un archivo de texto de una página podría tener un tamaño de unos pocos kilobytes, mientras que una película en alta definición podría tener un tamaño de varios gigabytes.

Más en Informática

- Extensión de archivos de vídeo ¿Qué son, para qué sirven y qué tipos hay?

- Extensión de archivo .MKV ¿Qué son y cómo reproducir este tipo de formatos de vídeo?

- ¿Cómo montar una estación meteorológica con Arduino? Guía paso a paso

- Archivos Torrent ¿Qué son, para qué sirven y cómo podemos descargarlos?

- Cibernética: Los inicios del transhumanismo y la idea de fusionar el cerebro humano con las máquinas

SÍGUENOS EN 👉 YOUTUBE TV

En conclusión, el bit y el byte son dos unidades de información distintas en la informática, siendo el byte la unidad básica de almacenamiento y procesamiento de información en los ordenadores modernos. Las diferentes escalas de medida de información son importantes para entender la cantidad de información que se maneja en diferentes contextos, y su importancia es crucial en la era de la información en la que vivimos hoy en día.

Historia del código binario ¿Cuándo se creó y cómo ha evolucionado su uso?

La historia del código binario se remonta a la antigüedad, aunque su uso en la informática moderna se desarrolló en el siglo XX. A lo largo del tiempo, el código binario ha sido una herramienta esencial para el procesamiento de información en los ordenadores, y ha permitido el desarrollo de la tecnología digital que utilizamos hoy en día.

A continuación, se describen los momentos históricos más importantes en la evolución del código binario:

Antigüedad

El uso del código binario en la antigüedad no estaba relacionado con la informática moderna, sino que se usaba para la representación de textos y números. Los egipcios, por ejemplo, utilizaban un sistema de numeración que se basaba en el uso de símbolos para representar diferentes cantidades. Los babilonios también usaban un sistema numérico basado en la posición de los símbolos, lo que permitía representar números muy grandes.

Siglo XIX

En el siglo XIX, el matemático alemán Gottfried Leibniz fue el primero en reconocer el potencial de un sistema de numeración basado en dos dígitos, en el que cada número se representa mediante dos símbolos: 0 y 1. Este sistema binario se convirtió en la base de los cálculos matemáticos de Leibniz, lo que permitió la simplificación de los procesos de cálculo y la resolución de problemas más complejos.

Siglo XX

Durante la Segunda Guerra Mundial, los sistemas de comunicación se convirtieron en una herramienta fundamental para el éxito de las operaciones militares. El desarrollo de la tecnología de comunicación y la necesidad de codificar y decodificar información de manera rápida y eficiente, llevó al desarrollo de la máquina Enigma, que utilizaba un código basado en el sistema binario. Este fue el primer sistema de codificación moderno que utilizaba el código binario, y se convirtió en la base de muchos otros sistemas de comunicación en el futuro.

En la década de 1940, el matemático estadounidense Claude Shannon desarrolló la teoría de la información, en la que demostró que cualquier mensaje o información podía ser representado mediante una secuencia de bits. Esto permitió el desarrollo de los primeros ordenadores electrónicos, que utilizaban el código binario para el procesamiento y almacenamiento de información.

Actualidad

En la actualidad, el código binario se utiliza en todos los aspectos de la informática moderna, desde los procesadores de ordenadores hasta la transferencia de información en Internet. Aunque el sistema binario puede parecer complejo e inaccesible, es esencial para el funcionamiento de la tecnología moderna y se ha convertido en una herramienta esencial para el procesamiento de la información en todos los ámbitos de la vida moderna.

Operaciones en código binario ¿Cómo funcionan?

El código binario se utiliza en la informática para procesar y almacenar información, y es esencial para el funcionamiento de los ordenadores y otros dispositivos electrónicos. Además de ser utilizado para representar números y letras, también se puede utilizar para realizar operaciones matemáticas como la adición y la multiplicación.

Es importante recordar que las operaciones en código binario son diferentes a las operaciones en el sistema decimal, y requieren de cierta práctica y comprensión para ser realizadas correctamente. Sin embargo, el uso del código binario es esencial para el funcionamiento de la tecnología moderna y permite el procesamiento de la información de manera rápida y eficiente.

Adición y multiplicación en código binario

La adición en código binario se basa en la misma lógica que en el sistema decimal, pero utilizando únicamente los dígitos 0 y 1. Cada número binario se compone de una serie de dígitos, y la suma se realiza de derecha a izquierda, de la misma manera que en el sistema decimal. Si la suma de dos dígitos es 0 o 1, el resultado se escribe en el mismo lugar. Si la suma es 2, se escribe un 0 y se lleva un 1 al siguiente dígito. Por ejemplo, 1+1 en binario es 10.

La multiplicación en código binario es un poco más compleja que la adición. Se utiliza el mismo proceso que en el sistema decimal, pero sólo se pueden multiplicar los dígitos 0 y 1. El proceso es similar al de la multiplicación en papel, pero sólo se utilizan las operaciones de suma y desplazamiento.

Si se multiplica un número binario por 0, el resultado siempre será 0. Si se multiplica por 1, el resultado es el número original. Si se multiplican dos números binarios de varios dígitos, se realizan varias multiplicaciones parciales, que se suman al final para obtener el resultado final.

![Cuales son los tipos de ciberacoso que existen actualmente en internet y las redes sociales Lista [year]](https://internetpasoapaso.com/wp-content/uploads/Cuales-son-los-tipos-de-ciberacoso-que-existen-actualmente-en-internet-y-las-redes-sociales-Lista-year.jpg)