Lo Último en IP@P

- Stellar Data Recovery revoluciona la recuperación de archivos perdidos en discos duros externos

- Goblin Mine: La Estrategia Económica Detrás del Juego de Minería que está Fascinando a Todos

- Estos son los nuevos Cargadores UGREEN: potencia y portabilidad en dos versiones que no te puedes perder

- UGREEN Nexode Pro: El Cargador Ultradelgado que revoluciona la carga de dispositivos móviles

- La computación en la nube está transformando los juegos Online y estas son sus grandes ventajas

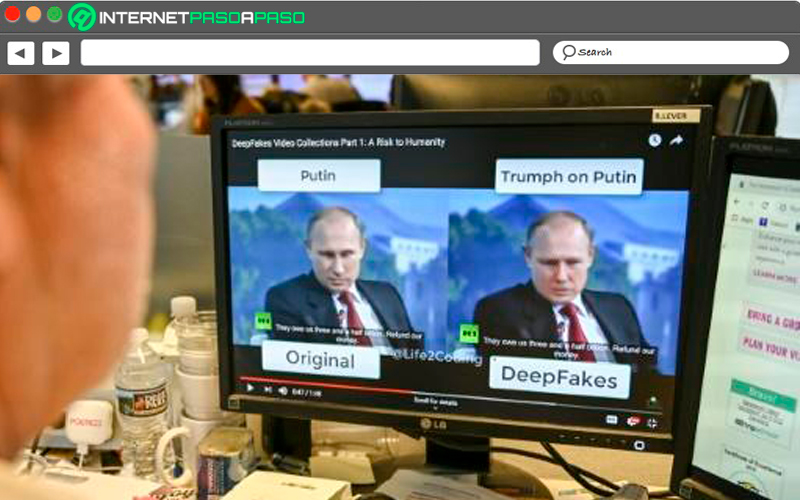

Imagínate esto: Haces clic en un vídeo de noticias y ves al "Presidente de los Estados Unidos" en una rueda de prensa con un líder de otro país. El diálogo es real... la rueda de prensa es real... y tú lo compartes con un amigo. Ellos la comparten con otros amigos y pronto, todo el mundo lo ha visto. Sólo más tarde te enteras de que la cabeza del presidente fue superpuesta en el cuerpo de otra persona. y nada de eso ocurrió realmente.

¿Suena inverosímil? No si has visto cierto vídeo viral del usuario de YouTube "Ctrl Shift Face" (puedes ver este vídeo al final del artículo). Desde agosto de 2019, ha conseguido más de 12,7 millones de visualizaciones y más de 16.000 comentarios a la fecha de escribir este artículo.

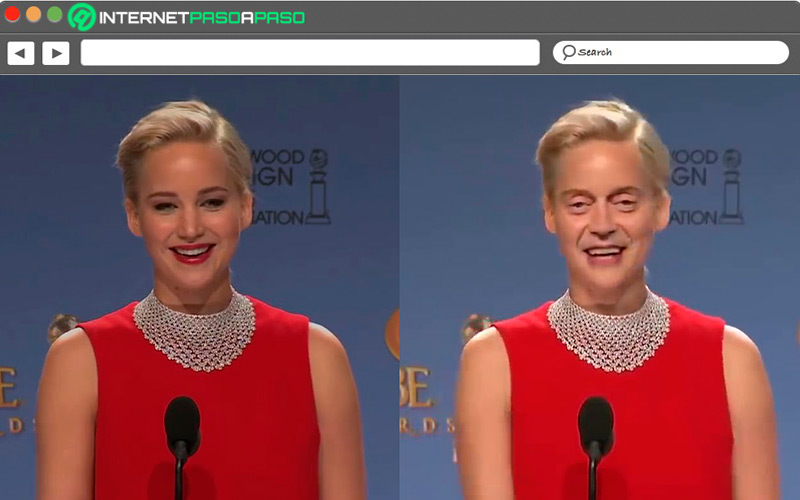

En ese vídeo, el comediante estadounidense Bill Hader comparte una historia sobre sus encuentros con Tom Cruise y Seth Rogen. Mientras Hader, un hábil imitador, hace su mejor imitación de Cruise y Rogen, los rostros de esos actores se funden a la perfección y de forma aterradora con el suyo. La tecnología del Deep Fake hace que las impresiones de Hader sean mucho más vívidas, pero también ilustra lo fácil -y potencialmente peligroso- que es manipular los contenidos de vídeo.

Pero... ¿Qué es un Deepfake?

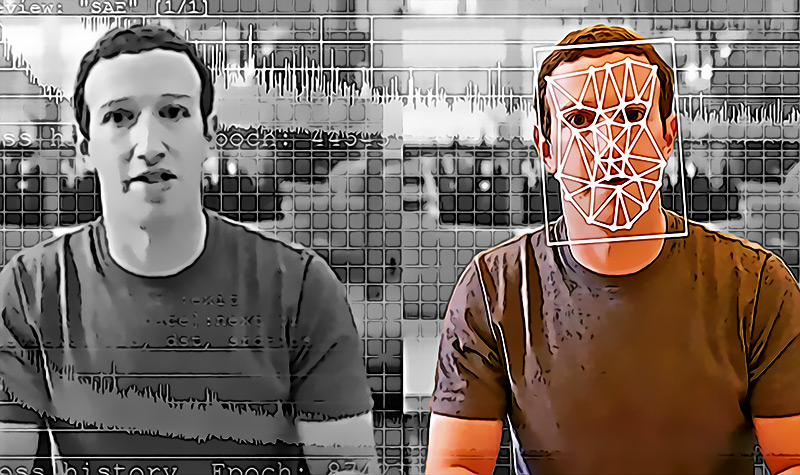

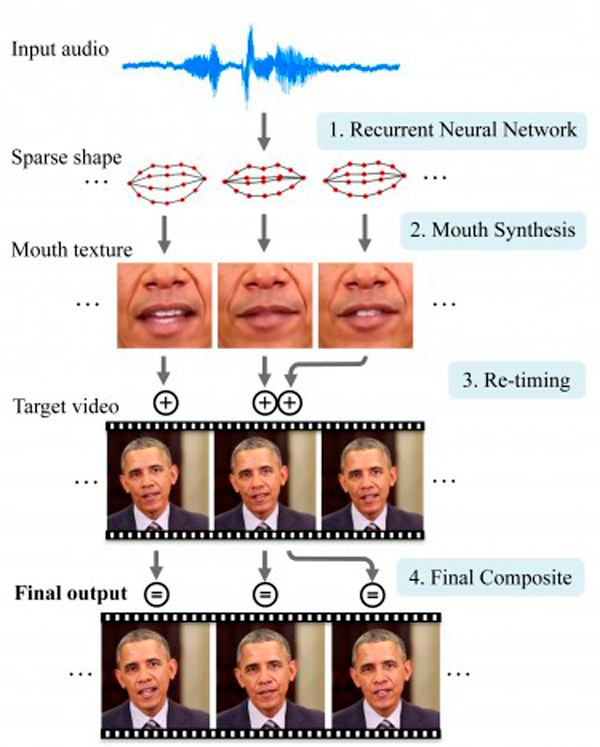

El vídeo de Hader es un deepfake elaborado por expertos, una tecnología inventada en 2014 por Ian Goodfellow, un estudiante de doctorado que ahora trabaja en Apple. La mayor parte de la tecnología de deepfake se basa en Redes Neuronales Generativas Adversarias (GANs).

Las GAN permiten a los algoritmos ir más allá de la clasificación de datos para generar o crear imágenes. Esto ocurre cuando 2 GANs intentan engañarse mutuamente para que piensen que una imagen es "real". Con tan solo una imagen, un GAN experimentado puede crear un clip de vídeo de esa persona. En 2019, el Centro de Inteligencia Artificial de Samsung publicó una investigación en la que se comparte la ciencia que hay detrás de este enfoque.

"Crucialmente, el sistema es capaz de inicializar los parámetros tanto del generador como del discriminador de una manera específica para la persona, de modo que el entrenamiento puede basarse en solo unas pocas imágenes y hacerse rápidamente, a pesar de la necesidad de afinar decenas de millones de parámetros".

"Demostramos que este enfoque es capaz de aprender modelos de cabezas parlantes altamente realistas y personalizados de personas nuevas e incluso de retratos"

Dijeron los investigadores detrás del documento.

Por ahora, esto sólo se aplica a los vídeos de "cabezas parlantes". Pero cuando el 47% de los usuarios ven sus noticias a través de contenidos de vídeo Online... ¿Qué ocurrirá cuando las GAN puedan hacer que la gente baile, aplauda o sea manipulada de alguna manera?

¿Por qué son peligrosos las Fakes News o noticias falsas?

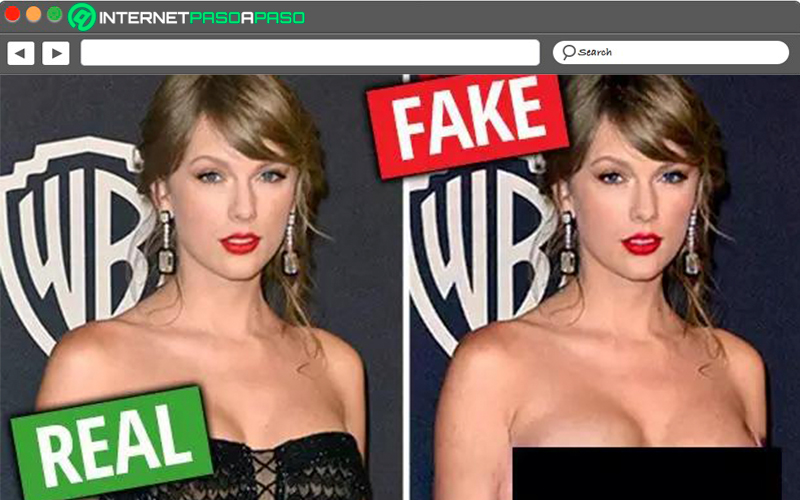

Si nos olvidamos del hecho de que hay más de 30 países involucradas activamente en la ciberguerra en cualquier momento, entonces la mayor preocupación con los deepfakes podría ser cosas como el mal concebido sitio web y app DeepNudes, donde los rostros de las celebridades y los rostros de las mujeres comunes podrían ser superpuestos en el contenido de un vídeo pornográfico.

El fundador de Deepnudes acabó cancelando el lanzamiento de la página web, temiendo que "la probabilidad de que la gente haga un mal uso de él es demasiado alta" Bueno, ¿Qué otra cosa podría hacer la gente con contenidos pornográficos falsos?

"En el nivel más básico, los deepfakes son mentiras disfrazadas para que parezcan verdades",

"Si los tomamos como verdades o pruebas, podemos sacar fácilmente conclusiones falsas con consecuencias potencialmente desastrosas"

Andrea Hickerson, directora de la Escuela de Periodismo y Comunicación de Masas de la Universidad de Carolina del Sur.

Gran parte del temor sobre los deepfakes se refiere, con razón, a la política, dice Andrea Hickerson: "¿Qué ocurre si un vídeo deepfake retrata a un líder político incitando a la violencia o al pánico? ¿Podrían otros países verse obligados a actuar si la amenaza fuera inmediata?"

Un uso que puede ser considerado de alto riesgo, es producir "noticias falsas" en periodos de elecciones en cualquier nación y esto sumado a la continua amenaza de ciberataques y ciberguerra, tenemos que considerar seriamente algunos escenarios "aterradores":

- Las deep fakes se utilizarán en periodos electorales para condenar al ostracismo, aislar y dividir aún más al electorado de cualquier país.

- Las deepfakes se utilizarán para cambiar e impactar en el comportamiento de voto, pero también en las preferencias de consumo de cientos de millones de personas.

- Los deepfakes se utilizarán en el spear phishing y en otras estrategias de ataque de ciberseguridad conocidas para dirigirse con mayor eficacia a las víctimas.

Esto significa que los deep fakes ponen en mayor riesgo a las empresas, los individuos y a los gobiernos.

"El problema no es la tecnología GAN, necesariamente"

"El problema es que los malos actores tienen actualmente una ventaja desmesurada y no existen soluciones para hacer frente a la creciente amenaza. Sin embargo, hay una serie de soluciones y nuevas ideas que están surgiendo en la comunidad de la IA para combatir esta amenaza. Aun así, la solución debe ser primero el ser humano"

Ben Lamm, CEO de la empresa de IA Hypergiant Industries.

Un nuevo peligro: Las estafas financieras deep fakes

¿Recuerdas tu primera llamada automática? Tal vez no, teniendo en cuenta que las llamadas telefónicas automatizadas eran bastante convincentes hace unos años, cuando la mayoría de nosotros aún no entendía lo que eran. Por suerte, esas llamadas estafadoras han ido disminuyendo: Se informa de que las quejas por robocalls han caído en los últimos años más de un 60%.

Sin embargo, la tecnología del deepfake aplicadas a las Fake News de audio podría reforzar fácilmente la táctica engañosa. Según Nisos, una empresa de ciberseguridad con sede en Alexandria, Virgina, los hackers están utilizando el aprendizaje automático para clonar las voces de las personas. En un caso documentado, los hackers utilizaron audio sintético deepfake en un intento de estafar a una empresa tecnológica.

Esto vino en forma de un mensaje de voz, que parecía provenir del CEO de la empresa de tecnología. En el mensaje, pide a un empleado que le devuelva la llamada para "finalizar un acuerdo comercial urgente"

"El destinatario inmediatamente pensó que era sospechoso y no se puso en contacto con el número, en su lugar lo remitió a su departamento legal, y como resultado el ataque no tuvo éxito", señala Nisos en un documento técnico de julio de 2020.

¿Qué se está haciendo actualmente para combatir las Fake News?

En los últimos años, el Comité de Inteligencia de la Cámara de Representantes de Estados Unidos envió una carta a Twitter, Facebook y Google preguntando cómo los sitios de medios sociales planeaban combatir los deepfakes en las próximas elecciones. La investigación se produjo en gran parte después de que el ex presidente Donald Trump tuiteara un video deepfake de la presidenta de la Cámara de Representantes, Nancy Pelosi.

En 2020, Facebook dio un paso positivo hacia la prohibición de los deepfakes. En una entrada de blog del 6 de enero, Monika Bickert, vicepresidenta de gestión de políticas globales de Facebook, escribió que la compañía está haciendo nuevos esfuerzos para "eliminar los medios manipulados engañosos."

Facebook está adoptando un enfoque específico y doble para marcar y eliminar los deepfakes en su plataforma. Para que una imagen sea retirada, debe cumplir los siguientes criterios, según la publicación del blog:

- Ha sido editada o sintetizada (más allá de los ajustes de claridad o calidad) de forma que no sea evidente para una persona normal y que pueda inducir a alguien a pensar que un sujeto del vídeo ha dicho palabras que en realidad no ha dicho.

- Es el producto de la inteligencia artificial o del aprendizaje automático que fusiona, sustituye o superpone el contenido a un vídeo, haciéndolo parecer auténtico.

Más en Web

- ¿Cuáles son las mejores páginas webs para ver el precio de las acciones y cotizaciones en Bolsa? Lista 2024

- ¿Cómo ver la TV online gratis por Internet de forma 100% legal? Guía paso a paso

- ¿Cuáles son las mejores páginas webs para contar las palabras o caracteres de un texto o web Online? Lista 2024

- ¿Cuáles son los mejores buscadores de internet alternativos a Google? Lista 2024

- VeoTorrent cierra ¿Qué es y cuáles son las mejores alternativas para descargar pelis y series Online? Lista 2024

SÍGUENOS EN 👉 YOUTUBE TV

Sin embargo, los vídeos de sátira y parodia siguen siendo seguros, al igual que los vídeos que se han editado únicamente para omitir o cambiar el orden de las palabras. Esto significa que los medios de comunicación manipulados todavía pueden pasar por las grietas. En particular, TikTok y Twitter tienen políticas similares.

Mientras tanto, instituciones gubernamentales como DARPA e investigadores de universidades como Carnegie Mellon, la Universidad de Washington, la Universidad de Stanford y el Instituto Max Planck de Informática también están experimentando con la tecnología deepfake. También lo está haciendo Disney. Estas organizaciones están estudiando cómo utilizar la tecnología GAN, pero también cómo combatirla.

Alimentando algoritmos de deepfakes y vídeos reales, esperan ayudar a los ordenadores a identificar cuándo algo es un deepfake y cuando es real. Si esto parece una carrera armamentística, es porque lo es. Estamos utilizando la tecnología para luchar contra la tecnología en una carrera que no tiene fin.

Noticias actuales confirman que la Unión Europea obliga a las grandes empresas tecnológicas gestionar y regular los deepfakes dentro de sus plataformas.

¿Cuáles son las soluciones contra la desinformación de las Fake News?

Quizá la solución no sea la tecnología. Otra investigación reciente sugiere que los ratones podrían ser la clave. Los investigadores del Instituto de Neurociencia de la Universidad de Oregón creen que "un modelo de ratón, dadas las potentes herramientas genéticas y electrofisiológicas para sondear los circuitos neuronales de que disponen, tiene el potencial de aumentar poderosamente la comprensión mecánica de la percepción fonética"

Esto significa que los ratones podrían informar a los algoritmos de próxima generación que podrían detectar vídeos y audios falsos. La naturaleza podría contrarrestar la tecnología, pero sigue siendo una carrera armamentística.

Aunque los avances en la tecnología de las Fake News podrían ayudar a detectar las falsificaciones, podría ser demasiado tarde. Una vez que se corroe la confianza en una tecnología, es casi imposible recuperarla. Si corrompemos la credibilidad en el vídeo, ¿Cuánto tiempo pasará hasta que se pierda la confianza en las noticias de la televisión, en los clips de Internet o en los acontecimientos históricos transmitidos en directo? Quizás ya vamos tarde...

"Los vídeos de "noticias falsas" amenazan nuestro discurso cívico y pueden causar graves daños psíquicos y de reputación a las personas. También hacen que sea aún más difícil para las plataformas participar en la moderación responsable de los contenidos Online.

"Mientras que el público está pidiendo, comprensiblemente, que las empresas de medios sociales desarrollen técnicas para detectar y prevenir la propagación de deepfakes"

Sharon Bradford Franklin, directora de políticas del Open Technology Institute de New America.

Si la legislación restrictiva no es la solución, ¿debería prohibirse la tecnología? Aunque muchos sostienen que sí, las nuevas investigaciones sugieren que las GAN podrían utilizarse para ayudar a mejorar los esquemas de multirresolución que permiten una mejor calidad de imagen y evitan los artefactos de parche en las radiografías, y que otros escenarios de uso médico podrían estar a la vuelta de la esquina.

¿Es eso suficiente para compensar el daño? La medicina es importante, pero también lo es garantizar la base de nuestra confianza de los contenidos que consumimos a diario en distintos medios de comunicación.

¿Cómo detectar un Deepfake? ¿Cómo saber que es real y qué es verdad?

Muchas personas ya han perdido su confianza en las noticias. Y a medida que la tecnología deepfake crece, el número de noticias falsas sólo van a ir en aumento.

"La mejor manera de protegerse de un deepfake es no tomar nunca un vídeo al pie de la letra". "No podemos asumir que ver es creer. El público debe buscar de forma independiente información contextual relacionada y prestar especial atención a quién y por qué alguien comparte un vídeo. En general, la gente es descuidada con lo que comparte en las redes sociales. Incluso si tu mejor amiga lo comparte, deberías pensar de dónde lo ha sacado. ¿Quién o qué es la fuente original?"

Andrea Hickerson, directora de la Escuela de Periodismo y Comunicación de Masas de la Universidad de Carolina del Sur.

La solución a este problema tiene que ser impulsada por los individuos hasta que los organismos reguladores, los tecnólogos o las empresas tecnológicas puedan encontrar una solución. Pero si no hay un impulso inmediato para encontrar una respuesta, podría ser demasiado tarde.

Lo que todos deberíamos hacer es exigir que las plataformas que propagan esta información rindan cuentas, que el gobierno haga esfuerzos para garantizar que la tecnología tenga suficientes casos de uso positivos para compensar los negativos, y que la educación garantice que reconozcamos los deepfakes y tengamos el suficiente sentido común para no compartirlos.

De lo contrario, podemos encontrarnos en una ciberguerra que un hacker inició basándose únicamente en un vídeo editado. ¿Y entonces qué?