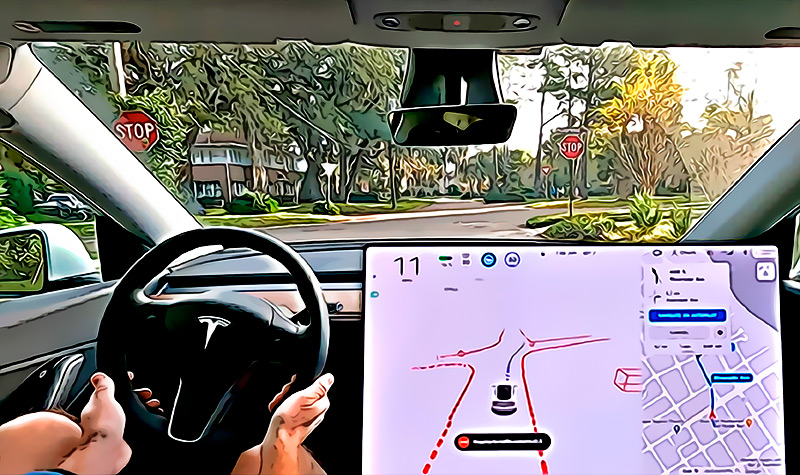

Este 26 de diciembre, se hizo eco de la nueva ley de California, en Estados Unidos, que prohíbe efectivamente que Tesla anuncie sus autos con la capacidad de autoconducción al 100%. Con la implementación de dicha ley estatal, el objetivo principal es regular lo ‘Full Self-Driving’ de la marca de Elon Musk y se aplicará en California a partir de 2023, para evitar los vehículos que no puedan ser automatizados completamente se vendan con un nombre confuso o como si fuera automáticos del todo.

Así, los expertos resaltan que las compañías deben informar sobre qué características y limitaciones tienen sus vehículos, así como también, sus especificaciones “parcialmente autónomas”. Cabe destacar que, la promulgación de esta ley surge por los numerosos accidentes viales que han generado los coches de Tesla, a causa de desperfectos en su sistema “AutoPilot” que alcanza el Nivel 2 de automatización en la conducción de un vehículo.

Nueva ley prohíbe a Tesla decir que sus coches son 100% autónomos

A finales de noviembre, Elon Musk anunció que la versión beta de ‘Tesla Full Self-Driving’ ya estaba disponible para cualquier persona en América del Norte y que este era un logro importante para el equipo Autopilot de la compañía. Desde entonces, el FSD Beta ha permitido que los usuarios de coches Tesla empleen cierto grado de conducción autónoma, en el que el conductor igualmente debe asumir el control del vehículo.

Tesla Full Self-Driving Beta is now available to anyone in North America who requests it from the car screen, assuming you have bought this option.

Congrats to Tesla Autopilot/AI team on achieving a major milestone!

— Elon Musk (@elonmusk) November 24, 2022

A pesar de que la función generó emoción en muchas personas, lo cierto es que también ha sido controversial. En ese momento, muchos señalaron que dicha característica de conducción no es confiable, pues ha quedado demostrado con los centenares de accidentes viales que esta ha producido, tanto en Estados Unidos como en varios países de Europa; a pesar de que la firma ha trabajado en esa versión desde 2020.

Por ende, los reguladores de California se vieron en la necesidad de promulgar un nuevo código que pueda restringir este tipo de conducción. Entre sus argumentos, señalan que el FSD de Tesla ofrece un “Nivel 2” y esto requiere un seguimiento constante por parte del conductor, a pesar de que pretende ser una conducción totalmente automatizada.

En consecuencia, en Estados Unidos, crearon la nueva ley de California que prohíbe efectivamente que la marca de Elon Musk anuncie sus prototipos como autoconducción. Si bien, ya existía una legislación que regulaba los vehículos autónomos equipados con tecnología que tiene la capacidad de conducir un vehículo sin el control físico activo o la supervisión de un operador humano, esto no incluía los sistemas para evitar colisiones. Lo cual, elevaba el nivel de riesgo de quienes fueran a bordo del vehículo de la marca Tesla.

En específico, los sistemas dedicados a prevenir colisiones hacían referencia a sistemas de frenado de emergencia automatizados, asistencia electrónica de punto ciego, asistencia de estacionamiento, asistencia de mantenimiento de carril, asistencia de cola, control de crucero adaptativo, advertencia de salida de carril, atascos de tráfico y otros sistemas similares.

Por supuesto, todos aquellos que son capaces de brindar una verdadera asistencia al conductor, mejorando su seguridad. Tomando en cuenta que, la función no puede operar sin el control activo o la supervisión de una persona.

Según Lena González, senadora demócrata en California, es esencial que cuando vendan coches con características “parcialmente autónomas” que requieren un conductor humano para monitorear el sistema de conducción, deben notificar a los distribuidores sobre qué especificaciones o limitaciones tienen. Dado que, aunque existe una regulación con la ley actual contra los anuncios falsos para poder tomar medidas enérgicas, la Oficina de Administración de Vehículos no la ha hecho cumplir.

El estado de California se cansó del mal uso del idioma por Tesla y lanzó una nueva ley para establecer que las automotrices tienen prohibido decir que un auto tiene la capacidad de automanejo, cuando solo está equipado con opciones de automatización parcial que exigen la supervisión humana.

De allí, la relevancia de evitar esta discrepancia con un nuevo proyecto de ley, el cual se aplicará en California a partir de inicios 2023. Por medio del proyecto de ley del Senado 1398 del senador González, admitido por el gobernador Gavin Newsom, el plan consiste en evitar que los automóviles que no puedan ser totalmente automatizados se vendan como si fueran 100% automáticos o con un nombre confuso que trate de engañar a los clientes.

Ante la noticia, la posición de Tesla fue la esperada. De inmediato, el reconocido fabricante de automóviles declaró que se oponía a este proyecto de ley, ya que siempre han informado a los compradores acerca de las restricciones sobre el software de conducción completamente automático. Por supuesto, este es un código que podría afectar las operaciones comerciales de la compañía y minimizar sus ganancias, ya que crea dudas sobre su legitimidad y seguridad.

A pesar de las aclaraciones por parte de Tesla, muchas personas consideran que engaña a los consumidores, debido a que sugiere un nivel de automatización que en realidad no brinda.

Recordamos algunos de los peores accidentes ocasionados por el AutoPilot de Tesla

A mediados de año, la NHTSA realizó una publicación en la que presenta los datos recabados entre julio de 2021 y mayo de 2022, con los que afirman que el AutoPilot de Tesla no es seguro. En vista de que, la compañía de Elon Musk protagonizó 273 colisiones en Estados Unidos, las cuales suponen el 69.6% del total registrado, que fue de 392 choques.

Ahora bien, aunque han sido numerosas colisiones, solamente algunas de ellas se han calificado como fatales o altamente graves. Así, entre los peores accidentes de tránsito producidos por fallos en coches de Tesla, se produjo hace poco en EEUU cuando el software de un prototipo de la marca decidió realizar una frenada abrupta en una autopista y con ello, causó un choque en cadena que dejó un saldo de 18 personas heridas.

Otro de estos incidentes, se desarrolló en China cuando un Tesla se volvió loco y aceleró a toda velocidad matando a 2 personas antes de estrellarse contra una casa, en noviembre.

Específicamente, las víctimas fueron un motorista y un estudiante que circulaba en su bicicleta, quienes fallecieron de manera instantánea en el lugar de los hechos. Todo quedó captado en las cámaras de seguridad ubicadas en las calles de Chazhou en la provincia de Guangdong, en donde se observa que el auto aceleró de forma súbita cuando se disponía a aparcar y perdió el control a lo largo de 2.6 kilómetros a toda velocidad. Las autoridades señalaron que se debió a un fallo en el AutoPilot del vehículo.

A finales de agosto, un Tesla Model 3 que tenía Tesla Autopilot activado chocó con dos coches en las inmediaciones de Orlando, Florida. Como resultado, el conductor del Model 3 de 27 años y el conductor del otro de los automóviles sufrieron heridas leves, pero no hubo que lamentar pérdidas humanas. Tras las investigaciones, hallaron que el problema se generó por el Tesla AutoPilot y en efecto, las autoridades sugirieron que Tesla debía claudicar y cambiar el nombre de su sistema de control de crucero.